生成式人工智能(GenAI)技术的浪潮正以前所未有的速度席卷千行百业,在催生新质生产力、重塑业务流程的同时,也彻底改写了企业安全风险的版图。尤其是当大模型及其驱动的智能体从实验室走向规模化产业应用时,其内生复杂性使得企业的运营管理难度与安全暴露面快速扩大。

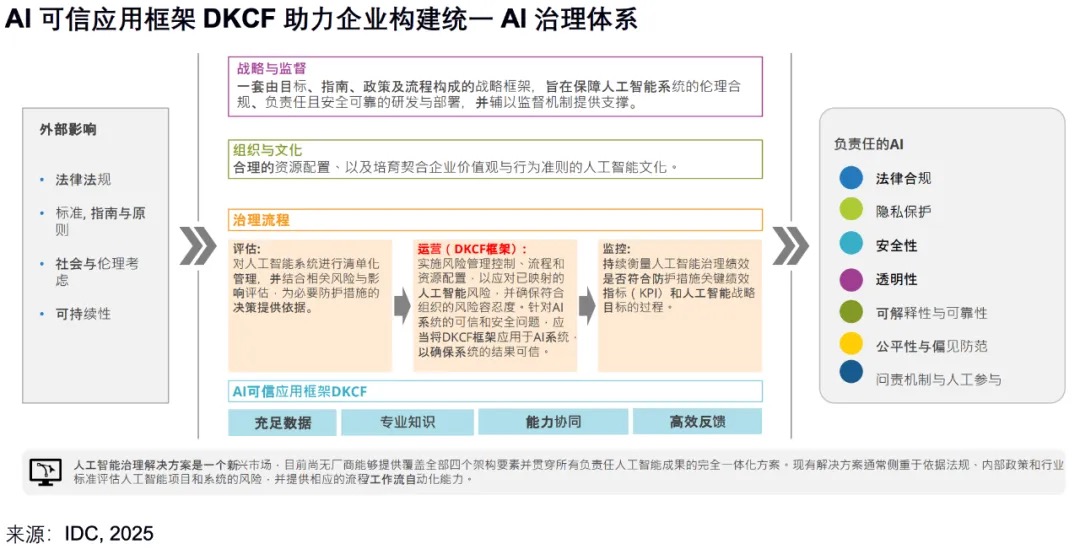

国际知名咨询机构IDC长期关注AI治理,近期IDC发布了《蚂蚁集团:大模型应用可信框架助力企业构建可信AI体系》报告,从定义、内容和最佳实践等角度详细介绍了蚂蚁集团提出的DKCF大模型应用可信框架,为企业构建可信AI体系提供参考。

IDC报告提及,伴随大模型、智能体在金融、政务、医疗、能源等行业应用落地不断加深,引入了诸多全新的、动态的安全风险,如模型幻觉、内容安全、数据安全等问题。IDC最新调研显示,超过 54%的最终用户对于大模型幻觉的问题表现出担忧,大模型训练、推理、反馈全流程的可信是最终用户用好大模型和智能体的根本。

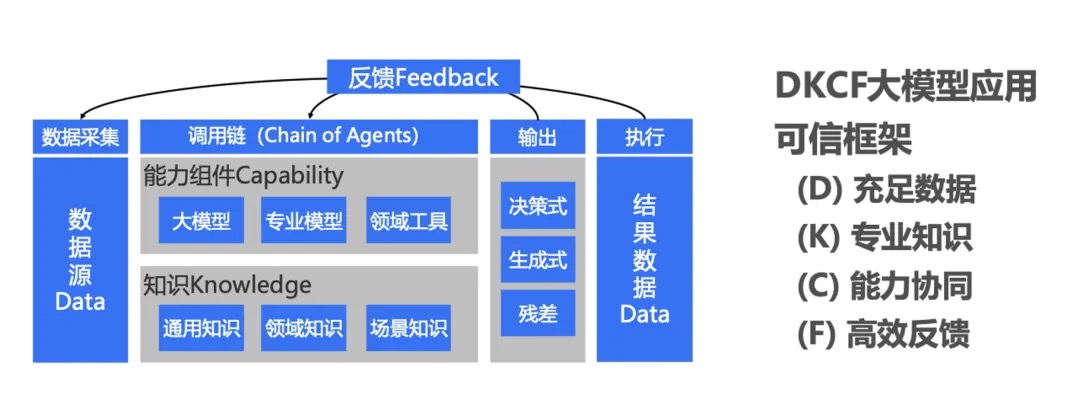

对于大模型执行过程中的可信问题,DKCF大模型可信应用框架给出了具体的应对思路和方法,尤其在处理模型幻觉上,对应用实践提供了指导。DKCF大模型应用可信框架,主要分为四大模块,分别为充足数据(D)、专业知识(K)、能力协同(C)和高效反馈(F):

其中,D代表丰富的数据源,确保大模型依赖充分的数据给出决策结果,解决大模型面临推理核验方面的挑战;

K表示高质量行业知识库,解决大模型面临的领域知识不足导致决策错误的问题;

C表示通过精细规划将复杂任务解构为更易操控和解决的子任务,解决专业领域复杂任务决策导致幻觉的问题;

F指通过构建一个闭环的业务流程使推理结果有效指导大模型决策,解决大模型在反馈循环上面临的低效问题。

总体来说,DKCF框架通过整合不确定性量化机制,使大模型能够自我评估其输出的确定性水平,以此来减少无依据的决策。此外,借助于专业知识图谱与大模型的深度融合,DKCF框架增强了领域知识的精确度和实时性。

目前DKCF大模型可信应用框架已在网络安全的实践应用中获得了良好的效果。在网络安全威胁检测中,告警研判是一个对专业知识要求较高且极其耗费人工的过程。蚂蚁集团基于DKCF框架构建了风险研判助手,其包含切面数据预处理模块、知识模块、Agent模块、线索模块、反馈循环模块,在降低告警研判人力投入的同时,也降低了对安全运营人员的知识水平的要求,并且可以有效缓解大模型幻觉问题,实现了网络安全威胁检测的效能提升。

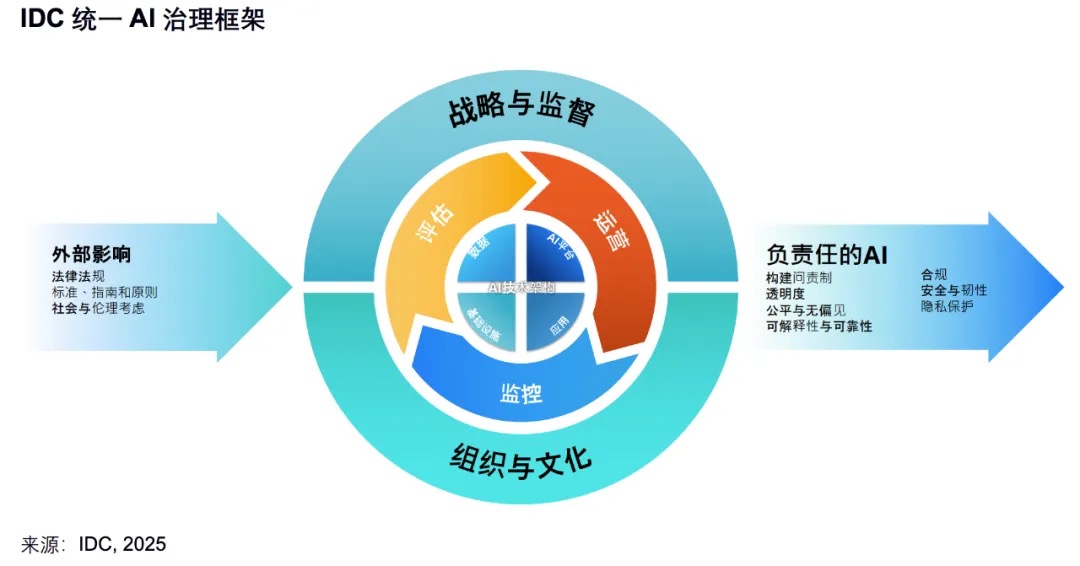

大模型执行过程中的可信和安全作为AI治理体系中的重要组成部分,需要在评估和运营阶段重点关注。同时,企业需要在战略上给予重视,用流程来规范责任与制度,用DKCF框架来保障大模型的可信和安全,用合作来构建安全可信生态,最终实现在安全可信的基础上用对、用好大模型和智能体的目标。具体来说,在评估阶段,需要用各类先进的评测技术如幻觉评测、注入攻击、越狱攻击等,评测AI应用系统的安全与可信,充分暴露问题。在运营阶段,针对安全与可信不足的AI应用系统,应当用DKCF可信框架进行改造。

下载报告全文

评论